1.5MapReduce计算任务的步骤(要深刻理解)

1.核心思想

分而治之,先分后和:将一个大的、复杂的工作或任务,拆分成多个小任务,最终合并。

是由Map和组成

Map:将数据进行拆分

:对数据进行汇总

1.2偏移量

行首字母或字符移动到当前文件的最前面需要移动的字符个数

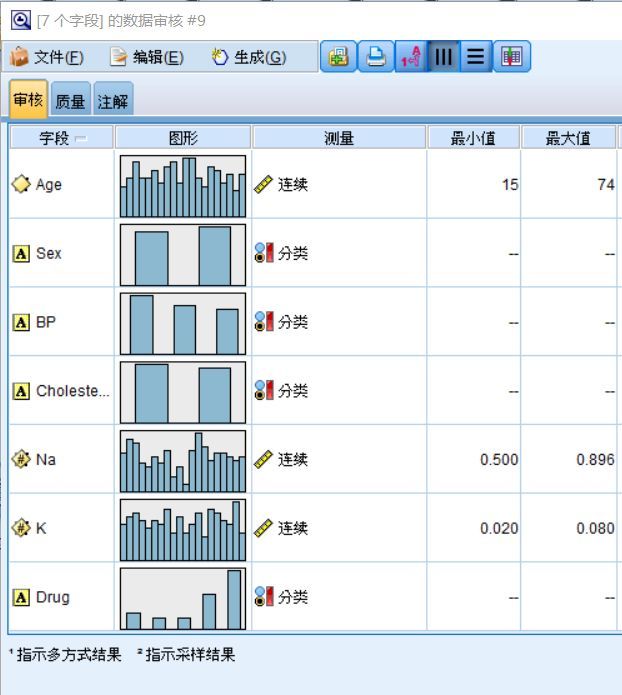

1.与Java数据类型对比

Java类型:int、long、, float、 、

类型:、、、、、[Text]、

1.输出理解

Map的输出是key value 的list

的输出是key value的list

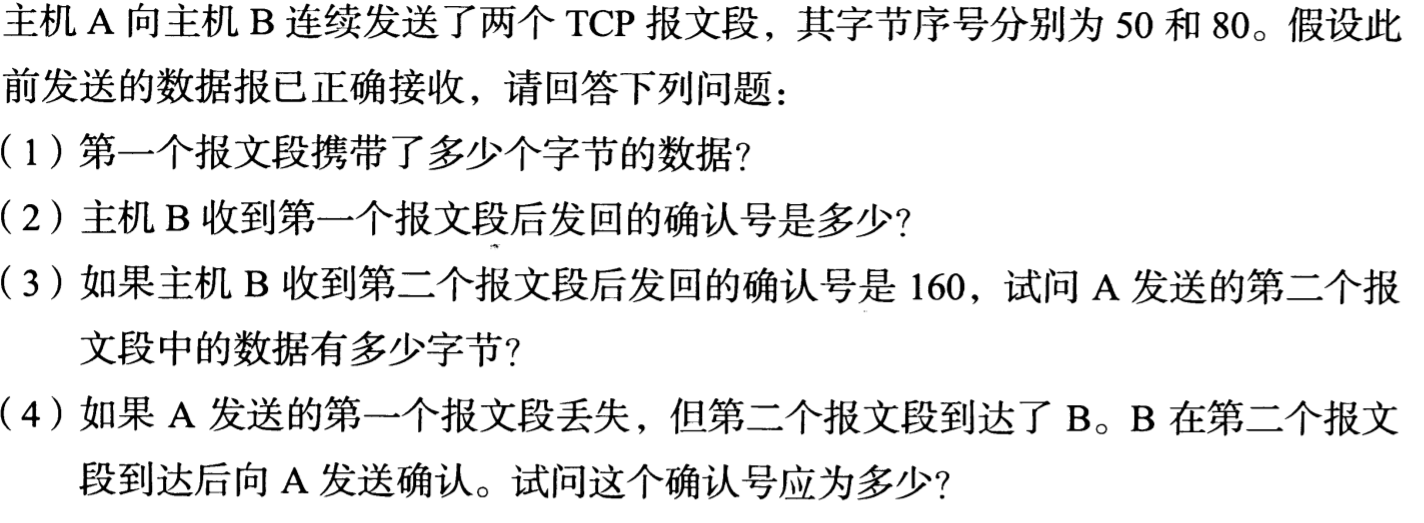

1.计算任务的步骤(要深刻理解)

第1步:

到hdfs上读取数据

将数据传给Split

第2步:Split

//设置读取数据的路径 .(job,new Path(“C:\bbb.txt”)); //3、设置Map job.(.class); //设置map输出的类型 job.(Text.class); job.ss(.class); //4、设置代码 job.(.class); //设置输出的类型 job.(Text.class); job.(.class); //5、设置读输出数据的class job.(.class); //设置输出数据的路径 .(job,new Path(“C:\ccc.txt”)); //6、等待代码执行(返回状态码) job.(true)?0:1;

Split将数据进行逻辑切分,

将数据传给RR

第3步:RR

RR:将传入的数据转换成一行一行的数据,输出行首字母偏移量和偏移量对应的数据

将数据传给MAP

第4步:MAP

MAP:根据业务需求实现自定义代码

将数据传给的

第5步:

:按照一定的分区规则,将key value的list进行分区。

将数据传给的Sort

第6步:Sort

Sort:对分区内的数据进行排序

将数据传给的

第7步:

:对数据进行局部聚合。

将数据传给的Group

第8步:Group

Group:将相同key的key提取出来作为唯一的key,

将相同key对应的value获取出来作为value的list

将数据传给

第9步:

:根据业务需求进行最终的合并汇总。

将数据传给

第10步:

:将数据写入HDFS

步骤总体流程图

Map将拆分的数据传给(混洗),而的底层原理又分为四步,分组完成后的数据在传入到

阶段的分区算法原理(很重要)

算法:对key进行哈希,获取到一个哈希值,用哈希值与的数量取余。余几,这个数据就放在余数编号的中。

Map的数量不能人为设置,的数量可以人为设置。数量越多,计算速度越快。

job.setNumReduceTasks(3);

打包代码到集群运行需添加驱动的类

job.setJarByClass(WordCountDriver.class);

的添加 对数据进行局部聚合。

job.setCombinerClass(WordCountReduce.class);

的意义就是对每一个 的输出进行局部汇总,以减小网络传输量

未使用的网络开销

1.6 Split的逻辑切分(重点)

获取到读取到的数据,对数据进行逻辑切分,切分的大小是128M.

这里的128 与HDFS数据块的128没有任何关系

HDFS 128 是存储层面的数据切分

是计算层面的128,只不过数据恰好相等。

两个128相同的原因是,一个集成程序能够正好计算一个数据块。