Meta Talk: Learning to Data

链接

摘要

音频驱动说话人脸,通过音频驱动说话人脸,由于其在虚拟现实中的广泛应用,在多模态学习中受到了相当大的关注。然而,大多数现有的音频驱动的说话人脸研究都需要长时间录制目标高质量视频,这显着增加了定制成本。本文提出了一种新颖的数据高效音频驱动的说话人脸生成方法,该方法仅使用一个短目标视频来生成由任意音频驱动的口型同步和高清人脸视频。目前的方法存在许多问题,例如清晰度低、嘴唇运动和声音不同步,以及对训练视频的强烈需求。在这项工作中,原始目标人物的人脸图像被分解为 3D 人脸模型参数,包括表情、几何、照明等。然后,由适应的目标人脸视频生成的低清晰度伪视频桥接强大的预训练音频驱动模型到我们的音频到表达转换网络,并帮助转移音频身份解开的能力。该表情通过音频替换,然后与其他面部参数组合以呈现合成面部。最后,神经渲染网络将合成人脸转换为说话人脸,而不会丢失定义。实验结果表明,与现有的最先进方法相比,所提出的方法在高清图像质量方面具有最佳性能,并且在唇部同步方面具有可比性。

关键字:说话的脸生成、唇形同步、高清、音频驱动的动画

1. 简介

人脸生成在多模态人机交互领域引起了广泛关注。其强大的通信方式使其广泛应用于虚拟教育、视频会议、虚拟主播、游戏娱乐、影视动画制作等领域。口型同步和逼真的视频肖像期间准确的嘴唇运动是更好的用户体验反馈的关键 [1, 2, 3, 4, 5],自然的头部姿势和眨眼也可以增强这些应用场景中的用户体验 [ 6、7、8]。然而,现有的说话人脸生成不能同时实现高清和口型同步。如何实现它们并开发音频驱动的说话人脸生成引起了许多研究人员的兴趣。

传统的基于图像的方法 [1] 需要大量目标角色的视频,因为它从数据库中检索最佳匹配的嘴唇图像并将其拼接回原始背景图像。基于 3D 可变形模型 (3DMM) [2] 的方法减少了目标视频获取的负担,但由于其音频驱动性能很大程度上取决于音频身份。基于 GAN [4] 的方法使用预训练的鉴别器来准确检测唇形同步错误,并强制生成器准确地生成唇形运动,使其与新音频同步。虽然它产生了不错的说话人脸唇形同步视频,并实现了音频身份与模型和目标身份的解耦,但唇部区域的定义对于视觉体验来说总是很差,无法满足应用需求。

在本文中,我们提出了一种新颖的说话人脸生成框架,并努力仅使用短训练目标视频将强大的音频驱动的唇形同步能力从预训练模型 [4] 转移到我们的模型中。本文的主要贡献总结如下:

(1) 在所提出的方法中,引入了由 [4] 预测的具有目标视频和 LRS2 音频 [9] 的低清晰度伪视频,以增强音频驱动的说话人脸生成的身份解纠缠能力。

(2) 我们训练了一个改进的音频到表达(A2E)网络,以保证由任意音频驱动的准确嘴唇运动,这使得我们的方法具有与 [4] 相媲美的强大音频驱动性能。

(3) 引入了修改后的裁剪模块,用于自动将 3DMM 合成人脸的大小适应原始人脸区域,从而使我们的框架能够满足 4K 清晰度照片般逼真的说话人脸视频的要求。

2. 我们的方法

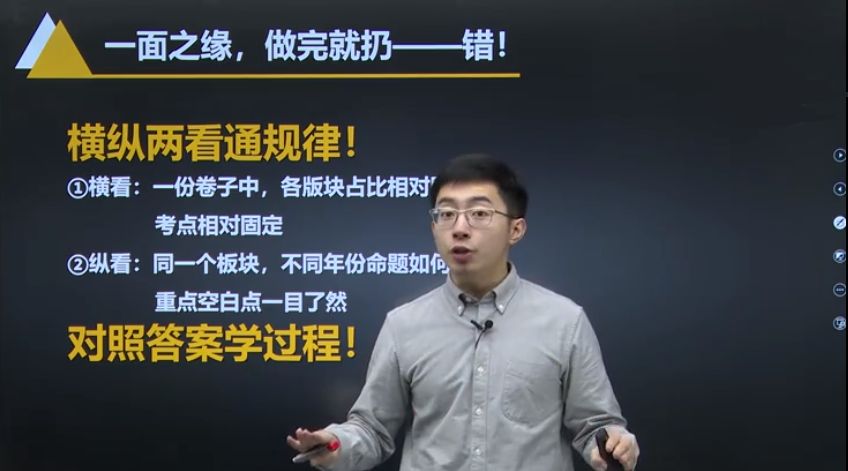

图1 总结了我们提出方法的流程。在训练阶段,我们首先将原始目标视频裁剪成目标人脸视频,然后将其调整为低分辨率,以使用预训练模型 [4] 生成带有 LRS2 [9] 音频的低清晰度说话人脸视频。生成的视音频对自成标签,具有丰富的音素和对应的说话人脸视频,具有出色的音画同步效果。对伪视频和目标视频都进行3D人脸重建,从它们的每一帧中提取面部3D可变形模型(3DMM)参数,包括表情、几何、纹理、姿势、光照系数。为了获得一个强大的将音频映射到表达系数的模型,我们使用伪视频的音频-表情系数对训练了一个新的audio-to-转换网络。然后,使用 3DMM 参数重新渲染目标视频中的合成人脸图像。最后,我们用合成和真实目标人脸的下半部分训练神经渲染网络,以生成高清照片般逼真的说话人脸视频。

在测试阶段,可以输入任意音频并将其馈送到经过训练的音频到表情转换网络,以预测音频驱动的表情参数。然后,我们使用预测的表情参数替换原始 3DMM 参数(通过 3D 重建获得的)。我们使用组合的 3DMM 参数将人脸重新渲染为音频驱动的合成人脸。然后将生成的合成人脸的下半部分转换为逼真的下半部分脸。最后,将生成的逼真的下半脸缝合到原始目标视频的背景中,生成高清唇形同步视频

2.1 图像裁剪预处理

图 1. 我们方法的框架,包括训练和测试过程。标记为灰色的模块需要训练,标记为蓝色的模块不需要。

给定目标视频,我们首先检测其人脸并将其裁剪成图像大小为 或 或 的目标人脸视频。图像大小适应原始视频的人脸分辨率。这一步,接着后面的3D重建和神经人脸渲染器生成,可以生成与目标人脸分辨率相同的人脸,便于高清人脸翻译。然后,将裁剪后的人脸视频调整为 大小的低分辨率视频。我们将此视频与 LRS2 音频 [9] 一起输入预训练的说话人脸生成模型 [4] 以获得伪视频。由 预测,伪视频具有低清晰度和良好的口型同步。在所提出的方法中,我们对伪视频进行 3D 重建以获得表情参数并训练 A2E 网络,并将 强大的唇形同步性能传输到我们的 A2E 网络。所以伪视频是我们的方法和 之间的重要联接。调整图像大小操作减小了伪视频的大小,但可以显着加快 3D 重建。我们的方法侧重于通过音频驱动从 3D 人脸重建中获得的表情参数,这不依赖于输入视频的帧大小,因此我们可以使用低清晰度伪视频来提取表情参数。

2.2 3D人脸重建

图 2. 我们实验中用于训练的目标角色视频。

为了生成音频驱动的说话人脸,首先应针对目标人脸视频和伪视频重建 3D 人脸模型。并且,从视频每一帧中提取表情、形状、纹理、光照、姿态系数,可以充分描绘出视频人的面部信息,便于渲染回合成人脸图像。由于 3DMM 的先验特,模型可以对帧分辨率和清晰度低的视频进行 3D 人脸重建,从而进行 3D 人脸参数估计。我们利用基于深度学习的人脸重建模型 [10],其中输入人脸 I I I 表示为 3DMM(一种参数化人脸模型)。然后训练一个深度 CNN,用于从输入的人脸 I I I 估计 3DMM 参数 Φ I \Phi_I ΦI。人脸形状系数 s s s 可以重建为 s = s ˉ + s=\bar{s}+ s=sˉ+ α T Ξ exp + β T Ξ geo \alpha^T \Xi_{\exp }+\beta^T \Xi_{\text {geo }} αTΞexp+βTΞgeo,面部反射率 r r r 被公式化为 r = r ˉ + γ T Ξ r e f r=\bar{r}+\gamma^{\{T}} \Xi_{r e f} r=rˉ+γTΞref 以描述面部纹理,其中 s ˉ \bar{s} sˉ 和 r ˉ \bar{r} rˉ 表示为平均面部形状和反射率, α ∈ \alpha \in α∈ R 64 , β ∈ R 80 , γ ∈ R 80 。

Ξ exp , Ξ geo , ξ ref \{R}^{64}, \beta \in \{R}^{80}, \gamma \in \{R}^{80}。\Xi_{\text {exp }}, \Xi_{\text {geo }}, \xi_{\text {ref }} R64,β∈R80,γ∈R80。Ξexp,Ξgeo,ξref 分别表示表情、形状和光照矩阵,它们都是通过主成分分析(PCA)从面部扫描数据中计算出来的。 s ˉ , r ˉ , Ξ geo \bar{s}, \bar{r}, \Xi_{\text {geo }} sˉ,rˉ,Ξgeo 和 Ξ r e f \Xi_{r e f} Ξref 采用 2009 年的巴塞尔人脸模型 [11]。并且,我们使用基于 CNN 的粗到细学习方法 [12] 用于获得基于 Face- [13] 的 Ξ exp \Xi_{\exp } Ξexp 。此外,我们使用球谐函数(SH)[14]来近似环境照明,并假设朗伯表面和远景照明来模拟照明。具有正常 k i k_i ki 和纹理 z i z_i zi 的顶点 μ i \mu_i μi 的放射性可以计算为 C ( k i , z i , δ ) = z i ∑ b = 1 B 2 δ b ψ b ( k i ) C\left(k_i, z_i, \delta\right)=z_i \sum_{b=1}^{B^2} \ \psi_b\left(k_i\right) C(ki,zi,δ)=zi∑b=1B2δbψb(ki),其中 ψ b : R 3 → R \psi_b: \{R}^3 \ \{R} ψb:R3→R 是 S H \{SH} SH 基函数, δ b \ δb 是 S H \{SH} SH 系数和 B = 3 B=3 B=3 波段。

这些结果导致 S H \{SH} SH 系数 δ ∈ R 27 \delta \in \{R}^{27} δ∈R27。针孔相机用于对虚拟相机进行建模,用于从 3D 到 2D 的透视投影。刚性头部姿势由旋转系数 R ∈ S O ( 3 ) R \in S O(3) R∈SO(3) 和平移系数 T ∈ R 3 T \in \{R}^3 T∈R3 表示。完整的3DMM系数表示为: Φ I = { α T , β T , γ T , δ T , R T , T T } T ∈ R 257 \Phi_I=\left\{\alpha^T, \beta^T, \gamma^T, \delta^T, R^T, T^T\right\}^T \in \{R}^{257} ΦI={αT,βT,γT,δT,RT,TT}T∈R257。我们采用与 [2] 相同的微调步骤来微调伪视频和目标视频的 3D 重建网络。

2.3 音频到面部表情映射

唇形同步的性能在很大程度上取决于从音频信号到面部表情的映射的构造,因为众所周知,嘴唇和下脸的运动与音频信号密切相关。丰富的音频表达对训练语料库是映射模型具有良好的任意音频驱动性能的重要前提。由于 LRS2 数据集 [9] 是来自 BBC 电视的大规模口语句子语料库,而 [4] 是在 LRS2 上训练的强大的口型同步生成模型,根据我们广泛的文献和用户研究实验,伪视频口型同步良好,它充满了丰富的音素和与之配对的口型同步视频。因此,我们使用 LRS2 音频 [9] 和从预训练生成模型 [4] 预测的伪视频估计的 3D 面部表情来构建有效的音频到表情转换网络。

首先,提取输入音频的 MFCC 特征并将其馈送到 AT-net[3] 以获得 256-D 高级特征 f。然后,建立一个 A2E 网络,将此特征映射到成对的 3D 面部表情参数。由于具有大量以及丰富的音频-表情对训练数据,我们在 [2]中深化了A2E网络,以增强网络的建模和拟合能力(见表1)

为了训练 A2E 网络 H,均方误差 (MSE) 损失 L A 2 E L_{A2E} LA2E 公式如下:

L A 2 E = M S E ( H ( f ) − α ) L_{A 2 E}=M S E(H(f)-\alpha) LA2E=MSE(H(f)−α)

其中 α \alpha α 是从伪视频估计的表情系数。

2.4 神经人脸渲染网络

在 3D 重建之后,可以使用估计的 3DMM 系数来渲染合成人脸图像。为了获得高质量的自然人脸图像,我们需要将合成的人脸图像转换为高清、逼真的人脸图像。

我们采用[2]的掩蔽策略获得合成人脸 I ~ \{I} I 和目标人脸 I I I 的下半部分,形成神经人脸渲染翻译的训练语料库。合成的渲染人脸通过神经渲染网络转换为目标人脸的逼真渲染。神经渲染网络由基于 U-Net 的生成器 G 和判别器 D 组成。我们通过修改基于 U-net 的人脸生成器的输入大小来调整目标人脸的分辨率。生成器由人脸编码器和人脸解码器组成。渲染人脸编码器是一堆下采样卷积层,它对合成人脸的下半部分进行编码并获得它的高级特征表示。然后由转置卷积堆叠解码器对该特征进行上采样,以合成高质量的输出。判别器使用 [15],训练生成器最小化生成的渲染人脸 G ( I ~ ) G(\{I}) G(I) 和真实人脸 I I I 的 L 1 L_1 L1 重建损失:

L r e c ( D ) = ∥ I − G ( I ~ ) ∥ 1 , L_{r e c}(D)=\|I-G(\{I})\|_1, Lrec(D)=∥I−G(I)∥1,

判别器 D 的输入是真实人脸 I I I 和渲染图片 G ( I ~ ) G(\{I}) G(I)。 GAN 的损失为:

L a d v ( G , D ) = log D ( I ) + log ( 1 − D ( G ( I ~ ) ) , L_{a d v}(G, D)=\log D(I)+\log (1-D(G(\{I})), Ladv(G,D)=logD(I)+log(1−D(G(I)),

因此,整个网络的损失函数为

L ( G , D ) = L r e c ( D ) + λ L a d v ( G , D ) L(G, D)=L_{r e c}(D)+\ L_{a d v}(G, D) L(G,D)=Lrec(D)+λLadv(G,D)

3. 实验

我们在从之前的工作 [2] 中收集的七个字符的视频(见图 2)上测试了我们的方法。其中只有 3 分钟用于训练模型。我们首先通过检测他们的人脸关键点来对齐所有说话的人脸,然后将视频裁剪为以人脸下半部分为中心的 或 帧大小。对于音频数据,类似于 [3],我们使用大小为 10 毫秒的窗口来提取 MFCC。然后,以中心图像帧用作配对图像数据,最终为每个音频块生成 28 × 80 MFCC 特征向量。

所有实验均使用 在单个 V100 上进行训练和测试。我们通过测试我们的方法,并且在多人音频的驱动性能上与 ATVG[3]、[4]、[2] 和 [5] 进行了比较。这些方法之间的比较结果如图3所示。

与其他四种方法相比,我们的方法产生更多同步的嘴唇运动。生成的视频可以更清晰地显示面部的更多纹理细节,甚至 F 脸上的雀斑也更清晰。然后,采用 [4] 中的指标 LSE-D 和 LSE-C 来定量评估在野外的唇形同步性能,并采用 FID [4] 和 SSIM 来评估图像质量(见表 2)。我们方法的口型同步性能与 相当,并且我们的方法在这些方法中产生具有最佳图像质量的视频。

表 3 显示了我们的消融研究,以证明我们对改进说话人脸生成的贡献。我们利用在 [2] 上收集的测试数据集的平均分数作为基线来比较我们的 A2E 网络的分数以及 LSE-D、LSE-C、FID 和 SSIM 上的高清修改。我们改进的 A2E 网络和高清修改分别在图像质量和口型同步方面提高了说话人脸视频的性能

4. 结论

在本文中,我们提出了一种新方法,可以仅使用 3 分钟的视频来生成具有高清晰度的口型同步说话人脸视频,从而实现数据高效的训练。给定任意任意音频输入,它可以在测试过程中驱动目标角色的语音视频生成。这种方法减轻了目标视频采集的负担,降低了虚拟现实应用的制作成本,可能会带来各种潜在的应用。在未来的工作中,我们将专注于基于目标身份解耦的说话人脸生成。

5. 参考

[1] “ obama: lip sync from audio,”ACM on , vol. 36, no. 4CD, pp.95.1–95.13, 2017.

[2] Xin Wen, Miao Wang, , Ze-Yin Chen,and Shi-Min Hu, “ audio- video ,” IEEE on and , vol. 26, no. 12, pp. 3457–3466,2020.

[3] Lele Chen, Ross K. , Duan, and Chen-liang Xu, “ cross-modal face with pixel-wise loss,” in 2019 IEEE/CVF on and (CVPR), 2019, pp. 7824–7833.

[4] K R , , Vinay P. , and C.V. , “A lip sync is all you need for to lip in the wild,” in of the 28th ACM on , New York, NY, USA, 2020, MM ’20, p.484–492, for .

[5] Yang Zhou, Han, Eli , Jose , , and Li, “,” ACM on , vol. 39,no. 6, pp. 1–15, Nov 2020.

[6] Zhang, Ni, Fan, Li, Ming Zeng, , and Guo, “3d face with pose ,” IEEE on and ,pp. 1–1, 2021.

[7] Yurui Ren, Ge Li, Chen, H. Li, and Shan Liu, “: image via ,” 2021.

[8] Zhang, Yifan Zhao, Yifei Huang, Ming Zeng, Ni, , and Guo, “: face with ,” CoRR, vol. abs/2108.07938, 2021.

[9] , Joon Son Chung, , Oriol , and , “Deep audio- ,” IEEE on and , pp. 1–1, 2018.

[10] Yu Deng, Yang, Xu, Dong Chen,Yunde Jia, and Xin Tong, “ 3d face with - : From image to image set,” in 2019 IEEE/CVF on and (CVPRW), 2019, pp. 285–295.

[11] , , Brian , Sami , and , “A 3d face model for pose and face ,” in 2009 Sixth IEEE on Video and Based , 2009, pp. 296–301.

[12] Guo, zhang, Cai, Boyi Jiang, and Zheng, “Cnn-based real-time dense face with - photo- face ,” IEEE on and , vol. 41, no. 6, pp. 1294–1307, 2019.

[13] Chen Cao, Weng, Shun Zhou, Tong, and Kun Zhou, “: A 3d for ,” IEEE on and , vol. 20, no. 3, pp.413–425, 2014.

[14] R. and P. , “An for maps,” of the 28th on and , 2001.

[15] Isola, Jun-Yan Zhu, Zhou, and A.Efros, “Image-to-image with ,” 2018.4852