语义分割算法性能比较_语义分割江湖的那些事儿——从旷视说起

今天的主题是 Face++ 组近两年持续在做的 相关工作,代表性成果主要有 1)GCN ()、2)DFN ()、3) ()。我们先来看一段演示 Demo:

DFN算法结果展示 回顾

介绍算法之前,我们先简单回顾一下语义分割( )的历史。众所周知,计算机视觉有三大核心任务——分类、检测、分割,三者号称是深度学习炼丹师的“三大浪漫”。分类针对整张图片,检测针对图片的局部,语义分割则如图1所示,旨在给输入图片上的每个像素赋予一个正确的语义标签。

图 1: VOC 2012 图片示例

传统的分割算法我们先按下不表。时间拨回到 2015 年,语义分割江湖之中,FCN 横空出世,自此 DL/NN 方法席卷了整个语义分割领域。短短几年,各个 的 state-of-the-art 不断刷新,成果喜人。

FCN 前期阶段,研究重点主要是解决“网络逐渐衰减的特征尺寸和需要原图尺寸的预测之间的矛盾”,换言之,就是如何解决网络不断 造成的信息损失;期间百家争鸣,百花齐放,涌现了希望保存或者恢复信息的 、 等方法,也出现了进行结构预测的各种花式 CRF 方法。

“大道之争”之中,碰撞出了两个最重要的设计:U-shape 和 Conv,据此形成当下语义分割领域网络设计最常见的两大派系:1)U-shape 联盟以 、GCN、DFN 等算法为代表;2) 联盟以 、 系列方法为代表;随着 Base Model 性能不断提升,语义分割任务的主要矛盾也逐渐渐演变为“如何更有效地利用 ”;这中间又是一番腥风血雨,我们今天介绍的 3 位主角也在其中贡献了一份力量。

介绍

语义分割任务同时需要 和 。今天我们介绍的三种算法都将从这两方面分别提出各自对应的解决方案。整体对比如下:

第一位主角是 算法 (GCN),江湖人送外号“Large ”。论文 Arxiv 链接请见:。

————

GCN 主要将 分解为: 和 两个问题。但是,这两个任务本质对特征的需求是矛盾的,需要特征对多种具有不变性,而 需要对 比较敏感。但是,普通的 Model大多针对 Issue设计,正如图2(b)所示,而这不利于 。

图2

所以,为了兼顾这两个 Task,本文提出了两个 :

从 来看,我们需要全卷积网络,而且不能有全连接或者全局池化等操作丢失位置信息。从 来看,我们需要让 Per-pixel 或者 Map 上每个点的连接更稠密一些,也就需要更大的 Size,如图 2(c) 所示。

——网络结构——

根据这两条 ,本文提出了 (GCN)。如图3所示,这个方法整体结构正是背景介绍中提到的U-shape结构,其核心模块主要包括:GCN 和 BR。

图3 网络结构

此处主要介绍GCN设计。正如图3(b)所示,它采用了较大 Size的卷积核,来同时解决上述的两个 Issue;然后根据矩阵分解,利用

和

的卷积来替代原来的

大核卷积。相对于原本的大核卷积,该设计能明显降低参数量和计算量。图4可视化了 Large Conv 和 普通 Conv网络有效感受野的对比。

图4

可以看到,Large Conv 的有效感受野显著增大。

——实验——

文中为了验证 Large Conv的有效性,对比了不同 Size的 ,可以看到 Size=15时比 Base 整整高了 5.5% mean IoU.

此外,文中还对 Large Conv 进行了一系列讨论。

通过实验结果可知,随着 Size的增加,普通 Conv的参数量远大于GCN,但是GCN的性能却持续地优于普通 Conv。

可以看到 GCN 依然优于普通 Conv 的堆叠,尤其是在较大 Size 的情况下。笔者认为这是一个很有价值的实验,可以启发我们去思考关于网络感受野的问题。我们以往认为,通过堆叠多个小核 Conv 可以达到和大核 Conv 一样的感受野,同时计算量还更少。最常见的应用比如 VGG-Net。但是,实际上并非如此。

随着网络深度的提升,理论上网络的感受野大多可以直接覆盖全图,但是实际有效感受野却远小于此。笔者的理解是对同一个 Map 进行卷积,边缘区域进行计算的次数会小于中心区域,所以随着 Conv 的不断堆叠,实际上会导致边缘感受野的衰减,即有效感受野会远小于理论感受野。

最后文中给出了在 VOC 2012 和 上完整的 ,这在当时还是很良心的,之前的一些 Paper 对此都语焉不详。具体详细的 过程请参考原文。

最终 GCN 在 VOC 2012 和 上都取得了不错的结果。

—— VOC 2012——

————

接下来出场的是 算法 (DFN)。论文Arxiv链接请见:。详细解读请见:CVPR 2018 | 旷视科技Face++提出用于语义分割的判别特征网络DFN。

————

本文总结了现有语义分割方法仍然有待解决的两类 (如图 5 所示):

图5

所以,本文从宏观角度出发重新思考语义分割任务,提出应该将同一类的 Pixel考虑成一个整体,也就需要增强类内一致性,增大类间区分性。总结而言,我们需要更具有判别力的特征。

——网络结构——

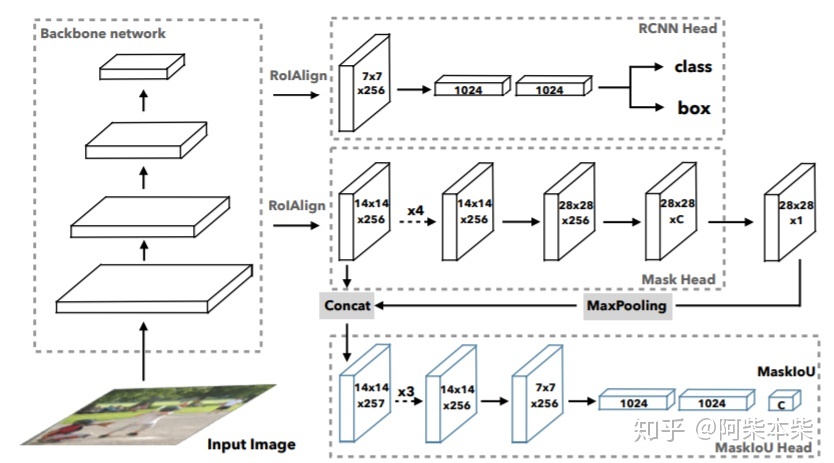

本文提出的DFN主要包括两部分: 和 ,如图6所示。

图6

主要解决类内不一致性问题。文中认为类内不一致性问题主要来自 的缺乏。进而,我们需要引入 Multi-scale 和 ;但是,不同 Stage 的特征虽然带来了 Multi-scale ,与此同时也带来了不同的判别能力;因此,我们需要对这些具有不同判别力的特征进行筛选,这就诞生了其中核心的设计—— Block(CAB)。

CAB 利用相邻 Stage 的特征计算 然后对 Low-stage 的特征进行筛选,如图 7 所示。因为文中认为,High-stage 的特征语义信息更强,更具有判别力。

图7

此外,本文首次在 U-shape 结构中采用 ,这个设计非常有效。 首次在语义分割中使用 提取 ,而之后的 , V3 将其在 阵营发扬光大。而本文将其应用 U-shape 的High-stage,并命名为“V-shape”。我们尝试将其迁移到 中的 FPN 结构,结果证明同样有效。

主要解决类间低区分性的问题。文中认为具有相似表观特征的不同区域很容易被网络混淆,尤其是相邻之时。所以,需要增大特征之间的区分性。为此文章显式地引入了 来引导特征学习。因为 Low-stage 主要关注一些细节边缘区域,而随着语义的增强,High-stage 的特征才是更多关注语义边界,所以 采用了“反 U-shape”结构。

——实验——

文中进行了丰富的消融实验和可视化分析。

首先是对 各部分的消融实验分析。可以看到 非常有效,在 VOC 2012 Set上可以达到 Scale 79.54% mean IoU。

而通过可视化输出,可以看到 确实可以将类内区域变得更加一致,如图8所示。

图8

同时,文中还对 和 进行了消融实验分析。

通过可视化 的输出,可以看到 确实可以很好地关注到 区域,如图9所示。

图9

最终,DFN在 VOC 2012和 上性能都达到了当时的state-of-the-art。

最后出场的主角是 ECCV 2018 算法 ()。前面两个算法主要关注 ,探索 mean IoU 的极限;而 关注于做出一个既快又好的实时语义分割算法。最终该算法在 上能取得 68.4% mean IoU 105 FPS ( Titan XP)的好成绩。当然,我们希望这篇工作能抛砖引玉,尝试探讨到底什么架构才更适合 任务,什么框架才能很好地同时获得充足的 和丰富的空间信息?论文 Arxiv 链接请见:。

详细解读请见:ECCV 2018 | 旷视科技提出双向网络:实现实时语义分割。

————

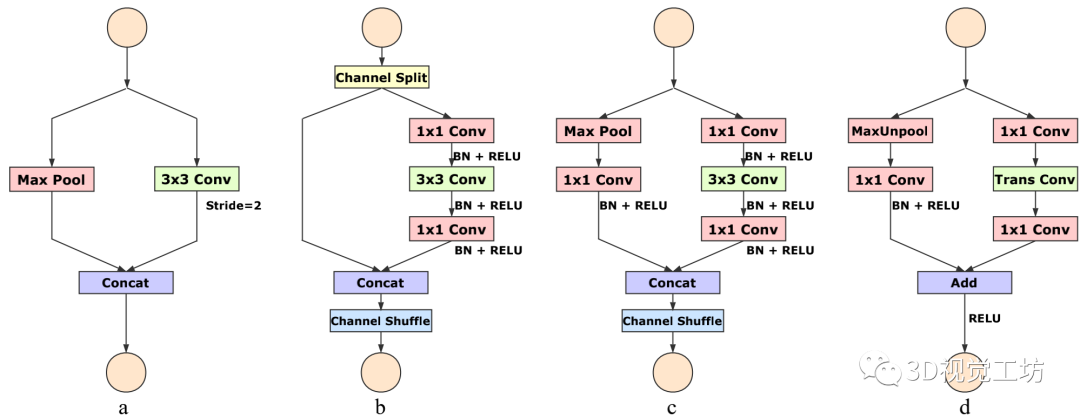

本文对之前的实时性语义分割算法进行了总结,发现当前主要有三种加速方法:1) 通过 Crop 或者 限制输入图片进而减少计算量;2) 减少网络通道数,尤其是 Early Stage;3) 还有像 ENet 类似的方法直接丢掉最后一个 Stage,如图10(a)所示。

这些提速的方法会丢失很多 或者牺牲 ,从而导致精度大幅下降。为了弥补空间信息的丢失,有些算法会采用 U-shape 的方式恢复空间信息。但是,U-shape 会降低速度,同时很多丢失的信息并不能简单地通过融合浅层特征来恢复,如图 10(b) 所示。

图10

总结而言,实时性语义分割算法中,加速的同时也需要重视空间信息。基于这些观察,本文提出了一种新的解决方案 ()。

——网络结构——

区别于 U-shape 和 结构,尝试一种新的方法同时保持 和 。所以,我们设计了 Path和 Path两部分。顾名思义, Path使用较多的 、较浅的网络来保留丰富的空间信息生成高分辨率特征; Path使用较少的 、较深的网络快速 来获取充足的 。基于这两路网络的输出,文中还设计了一个 (FFM)来融合两种特征,如图11所示。

图11

Path 只包含三个

的 Conv+BN+Relu,输出特征图的尺寸为原图的

。为了访存比考虑,此处并没有设计 结构。

Path 可以替换成任意的轻量网络,比如 , 系列, 系列。本文主要采用 和 -18 进行实验。可以看到,为了准确率考虑, Path 这边使用了类似 U-shape 结构的设计。不过,不同于普通的 U-shape,此处只结合了最后两个 Stage,这样设计的原因主要是考虑速度。此外,和 DFN 类似, Path 依然在最后使用了 来直接获取 。

最后,文章中提到因为两路网络关注的信息不同,属于 Level 的特征,所以文中设计了一个 FFM 结构来有效融合两路特征。

——实验——

本文从精度和速度两个维度,进行了丰富的分析实验。

首先文中分析了 Path 这边使用不同变体的 U-shape 结构的速度和精度的对比。

此处,U-shape-8s 就是文中所展示的结构,U-shape-4s 则是普通的 U-shape 设计,即融合了更多 stage 特征。可以看到,U-shape-4s 的速度会明显慢于 U-shape-8s.

文中还对 的各个部分进行了消融分析实验。

文中还给出了 的 、参数量等信息,以及在不同硬件平台不同分辨率下的速度对比。

文中给出了 分别与实时性算法和非实时性算法比较的结果。

与实时性算法比较:

虽然 是实时性算法,但是它的精度甚至比一些非实时性算法还高。

与非实时性算法比较:

可以看到, 是一种很有效的设计。当替换上大模型之后,精度甚至高于 等算法。另外,需要注意的是,为了和非实时性算法进行比较,在关注精度这部分实验 使用的不同于关注速度部分的 ,具体细节详见论文。

算法对实时性语义分割算法提出了新的思考,在提升速度的同时也需要关注空间信息。同时,该设计也是一次对 的思考,希望设计一个对 任务友好的框架,当然现在还存在许多需要改进的地方。此外,该方法不仅仅可应用于实时性语义分割算法,也可应用于其他领域,尤其是在对 和 同时有需求的情况下。据笔者了解,已有研究将其应用于 .

重要的事情

[1] Peng, C., Zhang, X., Yu, G., Luo, G., & Sun, J. (2017). Large — by . In and (CVPR), 2017 IEEE on(pp. 1743-1751). IEEE.

[2] Yu, C., Wang, J., Peng, C., Gao, C., Yu, G., & Sang, N. (2018). a for .arXiv arXiv:1804.09337.

[3] Yu, C., Wang, J., Peng, C., Gao, C., Yu, G., & Sang, N. (2018, ). : for real-time . on (pp. 334-349). , Cham.

[4] Long, J., , E., & , T. (2015). Fully for . of the IEEE on and (pp. 3431-3440).

[5] , O., , P., & Brox, T. (2015, ). U-net: for image . on image and - (pp. 234-241). , Cham.

---------解读者介绍-------

余昌黔,华中科技大学自动化系在读博士,旷视科技研究院算法实习生,语义分割算法DFN、 第一作者,研究方向涵盖语义分割、全景分割、快速分割、视频分割等,并在上述方向有着长期深入的研究;2018 年,参加计算机视觉顶会 ECCV 挑战赛 COCO+,分获全景分割( )两项冠军,并受邀作现场口头报告。个人网页:

Yu.me