计算机视觉的深度学习实战四:图像特征提取

计算机视觉的深度学习实战四:图像特征提取

综述:

几何特征 基于关键点的特征描述子 其他特征提取:(LBP、Gabor)代码实践 一、颜色特征 1、量化颜色直方图

2、聚类颜色直方图 lab空间是用数字化的方法来描述人的视觉感应。Lab颜色空间中: 3、 二、几何特征 1、边缘(Edge)

边缘提取:

三、基于特征点的特征描述子 1、几何特征:特征点/关键点 兴趣点/关键点( point/Key point)

2、几何特征:角点

角点()

数学模型:偏移(u,v)后窗内图像变化

判断角点:

3、FAST角点检测

4、几何特征:斑点 高斯拉普拉斯滤波/ of (LoG)

当sigma较小时,将识别出更为细节的边缘。

斑点(Blob) 局部特征:SIFT(尺度不变特征变换)Scale- 对关键点处理 关键点的方向估计关键点描述子的生成 特点: 独特性好,信息量丰富 多量性 计算快 可扩展性,可以很方便的与其他形式的特征向量进行联合。 尺度空间: 高斯金字塔就是在传统金字塔的基础上,对每一层用不同的参数σ做高斯模糊,是的每一层金字塔有多张高斯模糊图像,这样一组图像是一个。

SIFT-计算高斯差分(DoG)空间

SIFt-DoG空间极值点就是“关键点” 通过拟合三维二次函数来精确确定关键点的位置和尺度 同时去除低对比度的关键点和不稳定的边缘相应点(因为DoG算子会产生较强的边缘响应),以增强匹配稳定性、提高抗噪声能力。 SIFT-特征点方向估计 活取最高值方向为关键点主方向为了匹配的稳定性,将超过最高值80%的方向称为辅方向

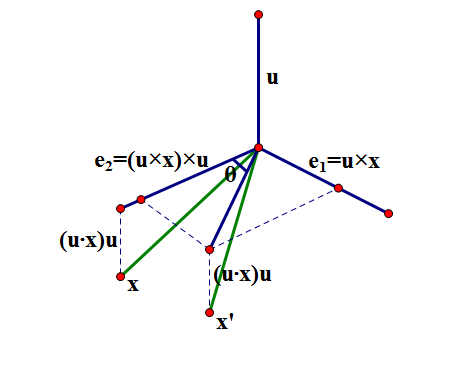

为了保证特征矢量具有旋转不变性,需要以特征点为中心,将特征点附近邻域内的图像旋转一个方向角θ即将原图像x轴转到与主方向相同的方向。

SIFT-计算特征点描述子 SIFT的缺点是:计算太复杂,如果不借助硬件加速或专门的图像处理器很难实现。

改进方式:Haar-like特征: Haar-like特征的快速计算:积分图 5、局部特征:SURF

SURF(Speed-Up )算子是 Bay等人在2006年提出的,它是对SIFT的改进,可将速度提高三倍。

SURF只要是把SIFT中的某些运算做了简化。

加速三倍亮度效果下效果好模糊方面优于SIFT尺度不变上不及SIFT旋转不变上差很多

6、ORB特征描述 ORB的基本思路 BRIEF的缺点是 7、BRIEF

点对的位置一旦随机选定,就不能再更改

ORB对BRIEF的改进 四、LBP

LBP(局部二值模式)

多个bit组成一个数,统计每个数的直方图

为解决旋转不变性的问题:将LBP周围的二进制码(如)按位旋转,取二进制码最小的值为最终LBP值。如:对于情况,我们按位旋转,得到,,,,,,七个不同的二进制数,最小值为.

改进的LBP: LBP特征具有灰度不变性和旋转不变性等显著优点。

五、Gabor Gabor滤波器组

Gabor滤波器

三尺度

八方向

六、代码实现 1、

import numpy as np

import cv2 as cv

filename = "picture/chessboard.png"

img = cv.imread(filename)

gray = cv.cvtColor(img,cv.COLOR_BGR2GRAY)

gray = np.float32(gray)

dst = cv.cornerHarris(gray,2,3,0.04)

#result is dilated for marking the corners, not important

dst = cv.dilate(dst,None)

# Threshold for an optimal value, it may vary depending on the image.

img[dst>0.01*dst.max()]=[0,0,255]

cv.imshow('dst',img)

if cv.waitKey(0) & 0xff == 27:cv.destroyAllWindows()

2、ORB

import numpy as np

import cv2 as cv

import matplotlib.pyplot as plt

img1 = cv.imread('picture/box.png',0) # queryImage

img2 = cv.imread('picture/box_in_scene.png',0) # trainImage

# Initiate ORB detector

orb = cv.ORB_create()

# find the keypoints and descriptors with ORB

kp1, des1 = orb.detectAndCompute(img1,None)

kp2, des2 = orb.detectAndCompute(img2,None)# create BFMatcher object

bf = cv.BFMatcher(cv.NORM_HAMMING, crossCheck=True)

# Match descriptors.

matches = bf.match(des1,des2)

# Sort them in the order of their distance.

matches = sorted(matches, key = lambda x:x.distance)

# Draw first 10 matches.

img3 = cv.drawMatches(img1,kp1,img2,kp2,matches[:20],None, flags=2)

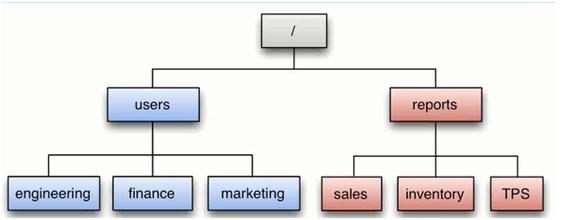

plt.imshow(img3),plt.show()3、图片拼接 (注意原始图片不能过大,否则报错,此处500*375)

from Stitcher import Stitcher

import cv2# 读取拼接图片

imageA = cv2.imread("image/3.png")

imageB = cv2.imread("image/4.png")# 把图片拼接成全景图

stitcher = Stitcher()

(result, vis) = stitcher.stitch([imageA, imageB], showMatches=True)# 显示所有图片

cv2.imshow("Image A", imageA)

cv2.imshow("Image B", imageB)

cv2.imshow("Keypoint Matches", vis)

cv2.imshow("Result", result)

cv2.waitKey(0)

cv2.destroyAllWindows()import numpy as np

import cv2class Stitcher:#拼接函数def stitch(self, images, ratio=0.75, reprojThresh=4.0,showMatches=False):#获取输入图片(imageB, imageA) = images#检测A、B图片的SIFT关键特征点,并计算特征描述子(kpsA, featuresA) = self.detectAndDescribe(imageA)(kpsB, featuresB) = self.detectAndDescribe(imageB)# 匹配两张图片的所有特征点,返回匹配结果M = self.matchKeypoints(kpsA, kpsB, featuresA, featuresB, ratio, reprojThresh)# 如果返回结果为空,没有匹配成功的特征点,退出算法if M is None:return None# 否则,提取匹配结果# H是3x3视角变换矩阵 (matches, H, status) = M# 将图片A进行视角变换,result是变换后图片result = cv2.warpPerspective(imageA, H, (imageA.shape[1] + imageB.shape[1], imageA.shape[0]))# 将图片B传入result图片最左端result[0:imageB.shape[0], 0:imageB.shape[1]] = imageB# 检测是否需要显示图片匹配if showMatches:# 生成匹配图片vis = self.drawMatches(imageA, imageB, kpsA, kpsB, matches, status)# 返回结果return (result, vis)# 返回匹配结果return resultdef detectAndDescribe(self, image):# 将彩色图片转换成灰度图gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)# 建立SIFT生成器descriptor = cv2.xfeatures2d.SIFT_create()# 检测SIFT特征点,并计算描述子(kps, features) = descriptor.detectAndCompute(image, None)# 将结果转换成NumPy数组kps = np.float32([kp.pt for kp in kps])# 返回特征点集,及对应的描述特征return (kps, features)def matchKeypoints(self, kpsA, kpsB, featuresA, featuresB, ratio, reprojThresh):# 建立暴力匹配器matcher = cv2.DescriptorMatcher_create("BruteForce")# 使用KNN检测来自A、B图的SIFT特征匹配对,K=2rawMatches = matcher.knnMatch(featuresA, featuresB, 2)matches = []for m in rawMatches:# 当最近距离跟次近距离的比值小于ratio值时,保留此匹配对if len(m) == 2 and m[0].distance < m[1].distance * ratio:# 存储两个点在featuresA, featuresB中的索引值matches.append((m[0].trainIdx, m[0].queryIdx))# 当筛选后的匹配对大于4时,计算视角变换矩阵if len(matches) > 4:# 获取匹配对的点坐标ptsA = np.float32([kpsA[i] for (_, i) in matches])ptsB = np.float32([kpsB[i] for (i, _) in matches])# 计算视角变换矩阵(H, status) = cv2.findHomography(ptsA, ptsB, cv2.RANSAC, reprojThresh)# 返回结果return (matches, H, status)# 如果匹配对小于4时,返回Nonereturn Nonedef drawMatches(self, imageA, imageB, kpsA, kpsB, matches, status):# 初始化可视化图片,将A、B图左右连接到一起(hA, wA) = imageA.shape[:2](hB, wB) = imageB.shape[:2]vis = np.zeros((max(hA, hB), wA + wB, 3), dtype="uint8")vis[0:hA, 0:wA] = imageAvis[0:hB, wA:] = imageB# 联合遍历,画出匹配对for ((trainIdx, queryIdx), s) in zip(matches, status):# 当点对匹配成功时,画到可视化图上if s == 1:# 画出匹配对ptA = (int(kpsA[queryIdx][0]), int(kpsA[queryIdx][1]))ptB = (int(kpsB[trainIdx][0]) + wA, int(kpsB[trainIdx][1]))cv2.line(vis, ptA, ptB, (0, 255, 0), 1)# 返回可视化结果return vis