ChatGPT 数据集之谜

这把火越烧越旺。国内很多大厂相继声称要做中文版,还公布了上线时间表,不少科技圈已功成名就的大佬也按捺不住,携巨资下场,要创建“中国版“。

不过,看看过去半个月在群众眼里稍显窘迫的Meta的,以及紧急发布的Bard,就知道在短期内打造一个比肩甚至超越效果的模型没那么简单。

让很多人不免感到诧异的是,的核心算法最初是由提出的,并且在大模型技术上的积累可以说不弱于,当然他们也不缺算力和数据,但为什么依然会被打的措手不及?

Meta首席AI科学家Yann LeCun最近抨击的名言实际上解释了背后的门道。他说,“只是巧妙的组合而已”,这句话恰恰道出了一种无形的技术壁垒。

简单来说,即使其他团队的算法、数据、算力都准备的与相差无几,但就是没想到以一种精巧的方式把这些元素组装起来,没有,全行业不知道还需要去趟多少坑。

即使给出了算法上的一条路径,后来者想复现,算力、工程、数据,每一个要素都需要非常深的积累。七龙珠之中,算力是自由流通的商品,花钱可以买到,工程上有这样的开源项目和团队,因此,对互联网大厂之外的团队来说,剩下最大的挑战在于高质量训练数据集。

至今,并没有公开训练的相关数据集来源和具体细节,一定程度上也暂时卡了追赶者的脖子,更何况,业界公认中文互联网数据质量堪忧。

好在,互联网上总有热心的牛人分析技术的细枝末节,从杂乱的资料中串联起蛛丝马迹,从而归纳出非常有价值的信息。

作者|Alan D.

翻译|杨婷、徐佳渝、贾川

出品 |

一些研究人员的报告称,通用人工智能(AGI)可能是从我们当前的语言模型技术进行演进[1],预训练语言模型为AGI的发展铺平了道路。虽然模型训练数据集日渐增大,但缺乏基本指标文档,包括数据集大小、数据集token数量和具体的内容细节。

尽管业内提出了数据集组成和整理文档的标准[2],但几乎所有重点研究实验室在揭示模型训练数据集细节这方面都做得不够。这里整合的研究涵盖了2018年到2022年初从GPT-1到的精选语言模型的所有数据集(包括主要数据集:和 Crawl)的综合视图。

概述

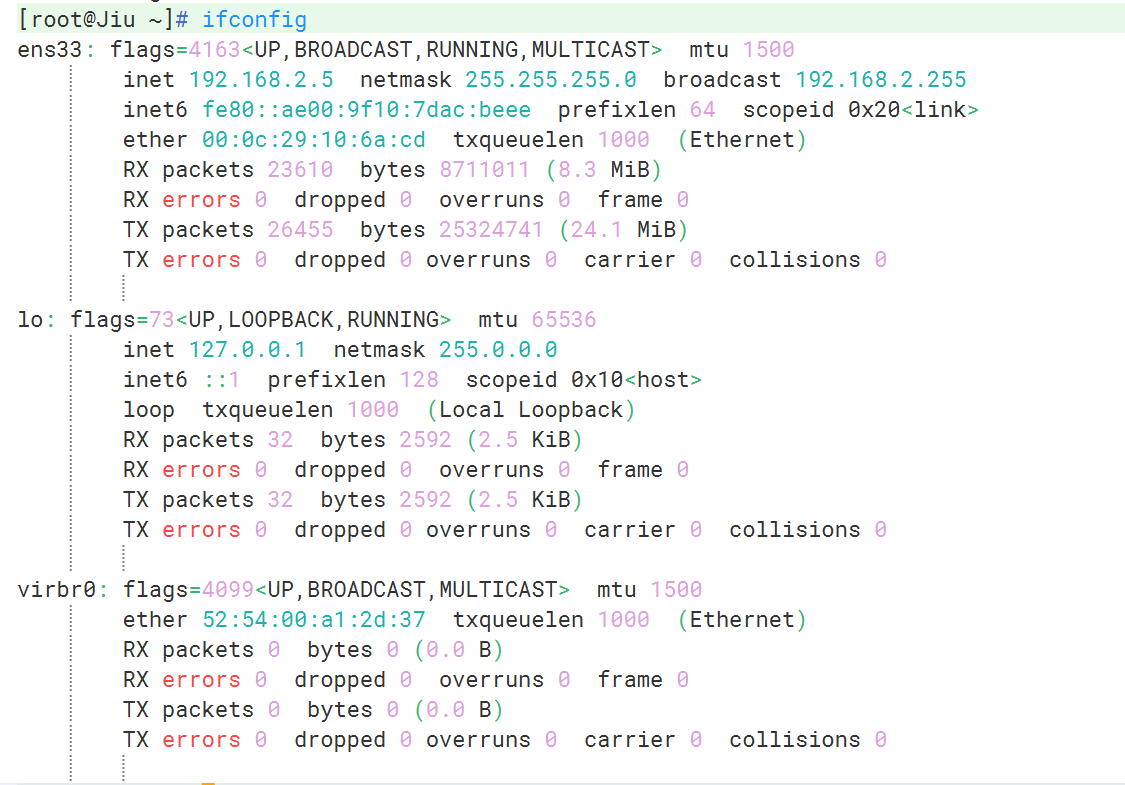

图 1. 主要数据集大小的可视化汇总。未加权大小,以GB为单位。

2018年以来,大语言模型的开发和生产使用呈现出爆炸式增长。一些重点研究实验室报告称,公众对大语言模型的使用率达到了惊人高度。2021年3月,宣布[3]其GPT-3语言模型被“超过300个应用程序使用,平均每天能够生成45亿个词”,也就是说仅单个模型每分钟就能生成310万词的新内容。

值得注意的是,这些语言模型甚至还没有被完全理解,斯坦福大学的研究人员[4]最近坦言,“目前我们对这些模型还缺乏认知,还不太了解这些模型的运转模式、不知道模型何时会失效,更不知道这些模型的突现性( )能产生什么效果”。

随着新型AI技术的快速发展,模型训练数据集的相关文档质量有所下降。模型内部到底有什么秘密?它们又是如何组建的?本文综合整理并分析了现代大型语言模型的训练数据集。

因为这方面的原始文献并不对外公开,所以本文搜集整合了二、三级研究资料,在必要的时候本文会采用假设的方式来推算最终结果。

在本文中,我们会将原始论文中已经明确的特定细节(例如token数量或数据集大小)归类为“公开的()”数据,并作加粗处理。

多数情况下,适当地参考二、三级文献,并采用假设的方式来确定最终结果是很有必要的。在这些情况下,token数量和数据集大小等细节是“确定的()”,并以斜体标记。

模型数据集可分为六类,分别是:维基百科、书籍、期刊、链接、 Crawl和其他数据集。

表1. 主要数据集大小汇总。以GB为单位。公开的数据以粗体表示。确定的数据以斜体表示。仅原始训练数据集大小。

1.1. 维基百科

维基百科是一个免费的多语言协作在线百科全书,由超过300,000名志愿者组成的社区编写和维护。截至2022年4月,英文版维基百科中有超过640万篇文章,包含超40亿个词[5]。维基百科中的文本很有价值,因为它被严格引用,以说明性文字形式写成,并且跨越多种语言和领域。一般来说,重点研究实验室会首先选取它的纯英文过滤版作为数据集。

1.2.书籍

故事型书籍由小说和非小说两大类组成,主要用于训练模型的故事讲述能力和反应能力,数据集包括 和 ( /)等。

1.3.杂志期刊

预印本和已发表期刊中的论文为数据集提供了坚实而严谨的基础,因为学术写作通常来说更有条理、理性和细致。这类数据集包括ArXiv和美国国家卫生研究院等。

1.4.链接

是一个大型数据集,它的数据是从社交媒体平台所有出站链接网络中爬取的,每个链接至少有三个赞,代表了流行内容的风向标,对输出优质链接和后续文本数据具有指导作用。

1.5. Crawl

Crawl是2008年至今的一个网站抓取的大型数据集,数据包含原始网页、元数据和文本提取,它的文本来自不同语言、不同领域。重点研究实验室一般会首先选取它的纯英文过滤版(C4)作为数据集。

1.6. 其他数据集

不同于上述类别,这类数据集由等代码数据集、 等对话论坛和视频字幕数据集组成。

常用数据集

2019年以来,大多数基于的大型语言模型 (LLM) 都依赖于英文维基百科和 Crawl的大型数据集。在本节中,我们参考了Jesse Dodge和(AI2)[8]团队的综合分析,按类别对英文维基百科作了高级概述,并在 Crawl数据集[7]的基础上,用谷歌C4[6] ( Clean )在 Crawl中提供了顶级域()。

2.1. 维基百科(英文版)分析

下面按类别[9]列出了维基百科的详细信息,涵盖了2015年抽样的1001篇随机文章,研究人员注意到随时间推移文章传播的稳定性。假设一个11.4GB、经过清理和过滤的维基百科英文版有30亿token,我们就可以确定类别大小和token。

表2. 英文维基百科数据集类别。公开的数据以粗体表示。确定的数据以斜体表示。

2.2 Crawl分析

基于 (AI2)的C4论文,我们可以确定,过滤后的英文C4数据集的每个域的token数和总体百分比,该数据集为305GB,其中token数为1560亿。

表3. C4:前23个域(不包括维基百科)。公开的数据以粗体表示,确定的数据以斜体表示。

GPT-1数据集

2018年,发布了1.17亿参数的GPT-1。在论文中,并没有公布模型训练数据集的来源和内容[10],另外,论文误将‘’拼写成了‘’。以作家未出版的免费书籍为基础,这些书籍来自于,这是一个自称为“世界上最大的独立电子书分销商” 的电子书网站。这个数据集也被称为 。经过几次重构之后,数据集的最终大小确定为4.6GB[11]。

2021年,经过全面的回顾性分析,数据集对按流派分组的书籍数量和各类书籍百分比进行了更正[12]。数据集中有关书籍类型的更多详细信息如下:

表4. 书籍类型。公开的数据以粗体表示,确定的数据以斜体表示。

在随后的数据集重构中,数据集进一步过滤掉了书籍中的“吸血鬼”类别、降低了言情类书籍的百分比、增加了“历史”类书籍,增加了收集的书籍数量。

3.1. GPT-1数据集总结

GPT-1最终的数据集总结分析如下:

表5.GPT-1数据集总结。以GB为单位。公开的数据以粗体表示,确定的数据以斜体表示。

GPT-2数据集

2019年,发布了拥有15亿参数的语言模型GPT-2。GPT-2论文阐明了所用训练数据集的大小[13],不过并未说明其内容。而GPT-2模型卡(model card)(在GPT-2 仓库中)说明了模型内容[14]。

我们可以从GPT-3论文中得到token数量,该论文使用了扩展版本来表示190亿token。据推测,2020年推出的扩展版本拥有12个月的额外数据( data),因此它可能比2019年推出的GPT-2版本大25%左右[15]。GPT-2最终的token数量确定为150亿左右。

如GPT-2论文所述,假设模型卡显示链接数时,每个链接都可以被4500万链接总数所除,那的内容在数据集中所占的百分比的详细信息就可以确定。

然后可以使用确定的150亿token数量来查找每个域的token数量。请注意,在可用的前1,000个域中,此处仅显示前50个域。

表6. : 前50个域。公开的数据以粗体表示,确定的数据以斜体表示。

4.1. GPT-2数据集总结

GPT-2模型最终的数据集总结分析如下:

表7. GPT-2数据集总结。公开的数据以粗体表示,确定的数据以斜体表示。

GPT-3数据集

GPT-3模型由于2020年发布。论文阐明了所用训练数据集的token数量[16],但训练数据集的内容和大小尚不清楚( Crawl的数据集大小除外[17])

表8. GPT-3数据集。公开的数据以粗体表示,确定的数据以斜体表示。

5.1. GPT-3:关于和数据集的分析

特别值得关注的是,在的GPT-3论文中,并未公开数据集(120亿token)和数据集(550亿token)的大小和来源。关于这两个数据集的来源人们提出了几个假设,包括来自和Sci-Hub的类似数据集,不过这两个数据集常以TB为计,大到无法匹配。

5.2. GPT-3:

GPT-3使用的数据集不可能与GPT-1使用的数据集相同,原因在于的数据集更大,达120亿token。在一篇引用的论文[19]中就提及GPT-1使用的数据集拥有9.848亿个词,但这可能只相当于13亿token(984.8字x 1.3字的token乘数)。

通过标准化项目古腾堡语料库(SPGC),有可能与古腾堡项目保持一致性。SPGC是一种开放式科学方法,被用于古腾堡项目完整的PG数据的精选()版本。SPGC包含120亿个token[20],大约为21GB[21]。

5.3. GPT-3:

(550亿token)可能与保持一致,并由收集该来源的数据,组成数据集,使其成为The Pile v1的一部分。版本为100.96GB[22],其确定的token数仅为250亿,低于公开的550亿。然而,使用SPGC的‘每字节token数’比率(大约为1:1.75),的token数和大小将更接近于。

5.4. GPT-3数据集总结

附录A概述了使用 + + 数据集的顶级资源列表。GPT-3模型的最终数据集总结分析如下:

表9.GPT-3数据集总结。公开的数据以粗体表示,确定的数据以斜体表示。

The Pile v1(GPT-J和GPT-NeoX-20B)数据集

The Pile v1数据集由于2021年发布,该数据集已被用于训练包括GPT-J、GPT-NeoX-20B在内的多种模型,并作为包括MT-NLG在内的其他模型的部分数据集。The Pile v1论文阐明了所用训练数据集的来源和大小。随着token数量的增加,The Pile v1论文应被用作未来数据集文档的黄金标准。

有关token数量的更多详情,可以使用本文提供的信息来确定,参见表1(大小以GB为单位)和表7(token/每字节)[23]。

表10. The Pile v1数据集。公开的数据以粗体表示,确定的数据以斜体表示。

6.1. The Pile v1分组数据集( )

为了确定如‘Books’、‘’和‘CC’这类数据集的大小,笔者对数据集进行了分组,如下表所示。

表11. The Pile v1分组数据集(不包括、CC 和 )。公开的数据以粗体表示,确定的以斜体表示。

6.2. The Pile v1数据集总结

The Pile v1数据集与GPT-J和GPT-NeoX-20B模型的最终数据集总结分析如下:

表 12. Pile v1 数据集总结。公开的数据以粗体表示,确定的数据以斜体表示。

-11B和数据集

2019年,Meta AI(当时称之为 AI)和华盛顿大学联合发布了拥有1.25亿参数的模型。次年,Meta AI发布了拥有110亿参数的-11B模型。-11B使用的训练数据集与相同。[24]论文阐明了所用训练数据集的内容,不过必须参考引用的论文(BERT[25]和[26])来确定最终的数据集大小。

:确定的数据集为4.6GB,如上面的GPT-1部分所示。

维基百科:公开的数据集为“16GB(加上英文维基百科)”。在减去数据集(4.6GB,如上面的GPT-1部分所述)后,维基百科数据集确定为11.4GB。

CC-News:(经过滤后)公开的数据集为76GB。

:公开的数据集为38GB。

:公开的数据集为31GB。请注意,此数据集是“基于常识推理任务问题”的 Crawl内容,不属于本文的‘Books’类别。相反,将与CC-News数据集(76GB)相结合, Crawl的总数据集则为107GB。

7.1. -11B和的数据集总结

-11B和最终的数据集总结分析如下:

表13. -11B和的数据集总结。公示的数据以粗体表示,确定的数据以斜体表示。

MT-NLG数据集

2021年,英伟达和微软发布了拥有5300亿参数的语言模型MT-NLG。MT-NLG是微软 NLG(拥有170亿参数)和英伟达-LM(拥有83亿参数)的“继任者”。MT-NLG论文阐明了所用训练数据集的来源和token数量,不过没有明确指出数据集的大小。

如前所述,有关数据集大小的更多详情,可以使用The Pile v1论文中提供的信息来确定。虽然使用的组件相同,但注意的是,MT-NLG和The Pile v1中报告的组件大小却各不相同,这是由于来自 AI (The Pile v1数据集)和/ (MT-NLG模型)的研究人员采用了不同的数据过滤和去重方法。

8.1. MT-NLG中的 Crawl数据集

Pile-CC:公开的数据集为498亿token,确定的数据为227.12GB左右,参见上述Pile v1部分。

CC-2020-50:公开的数据集为687亿token,假设token的每字节率(per byte rate)为0.25 TpB=274.8GB。

CC-2021-04:公开的数据集为826亿token,假设token的每字节率为0.25 TpB=330.4GB

(来自/-11B):显示为219亿token。根据论文[27],数据集确定为120GB。

CC-(来自/-11B):公开的数据集为53亿token,如上述部分所示,数据集确定为31GB。

根据以上来源,可确认 Crawl的总数据量为983.32GB,共计2283亿token。

8.2. MT-NLG分组数据集( )

表14. MT-NLG 分组数据集。公开的数据以粗体表示,确定的数据以斜体表示。

8.3. MT-NLG数据集总结

MT-NLG模型最终的数据集总结分析如下:

表15. MT-NLG数据集总结。公示的数据以粗体表示,确定的数据以斜体表示。

MT-NLG 数据集数据集

模型由于2021年发布,有2800亿参数。该论文清楚地说明了所使用训练数据集所包含的高级token数量和大小[28],但没有说明详细内容。

表16. 公开的数据集 ()。公开的数据以粗体表述,确定的数据以斜体表示。

有趣的是,据论文披露:其Books数据集中包含一些超过500年历史(1500-2008)的书籍。

9.1. 数据集分析

于2014年被谷歌收购,并在创建时获得了海量数据。虽然论文中没有进一步详细描述,但第44页附录中的表A3b注明了中出现的前20个域[29]。根据披露的每个域所占的百分比,我们可以使用的总token数(5060亿token)和总原始大小()来确定每个域的token数量和大小。

表17. :前20个域。公开的数据以粗体表示,确定的数据以斜体表示。

9.2. :关于维基百科数据集的分析

维基百科数据集的总规模很难确定。在论文中,研究人员指出维基百科没有进行数据去重[30]。然而,论文中列出的不同大小数据集(12.5GB 与1GB )可能是由于失误而造成的,误将“10GB”写成了“1GB”。无论如何,本文仅使用数据集版本 (12.5GB)。

9.3. :不包括

数据集的组成部分不包括外链的数据集。为了清楚起见,尽管是中的顶级域,但该数据集仅抓取域内的链接。根据定义,[31]由“所有的外链”组成(即指向域外的链接)。

9.4. 分组数据集

被认为是的子组件,并被集成到的数据集汇总中,其分组基于以下列出的可用信息:

表18. 分组数据集。公开的数据以粗体表示,确定的数据以斜体表示。

9.5. 数据集总结

是本文中最大的数据集,大小为10.5TB。模型的最终数据集总结分析为:

表19. 数据集总结。公开的数据以粗体表示,确定的数据以斜体表示。

结论

对于训练当代大型语言模型的数据集而言,这可能是最全面的整合分析内容(截止2022年初)。在主要数据源不透明的情况下,本次研究主要从二级和三级来源收集数据,并经常需要假定来确定最终估计值。随着研究人员要处理千万亿个token(1,000万亿)和数千TB的数据(1,000TB),确保详细披露数据集组成的文档变得越来越重要。

特别值得关注的是,基于大型语言模型的强大AI系统产生的冗长而匿名的输出正在迅速发展,其中许多数据集的细节内容几乎没有文档说明。

强烈建议研究人员使用突出显示的“数据集的数据表( for )”论文中提供的模板,并在记录数据集时使用最佳实践论文(即Pile v1论文,包括token数量)。数据集大小(GB)、token数量(B)、来源、分组和其他详细信息指标均应完整记录和发布。

随着语言模型不断发展并更广泛地渗透到人们的生活中,确保数据集的详细信息公开透明、所有人都可访问且易于理解是有用、紧迫和必要的。