[爬虫]3.3.1 常见的反爬虫策略

文章目录

许多网站为了保护自己的数据,会用各种策略来阻止或限制爬虫的行为。下面是一些常见的反爬虫策略: 1. User-Agent检查

User-Agent是HTTP请求头的一部分,它告诉服务器发出请求的客户端的类型和版本。许多爬虫会使用默认的或者假的User-Agent,而网站可以通过检查User-Agent来判断请求是否来自爬虫。

例如,一个网站可能会拒绝所有User-Agent为-/2.18.4的请求,因为这是的库的默认User-Agent。

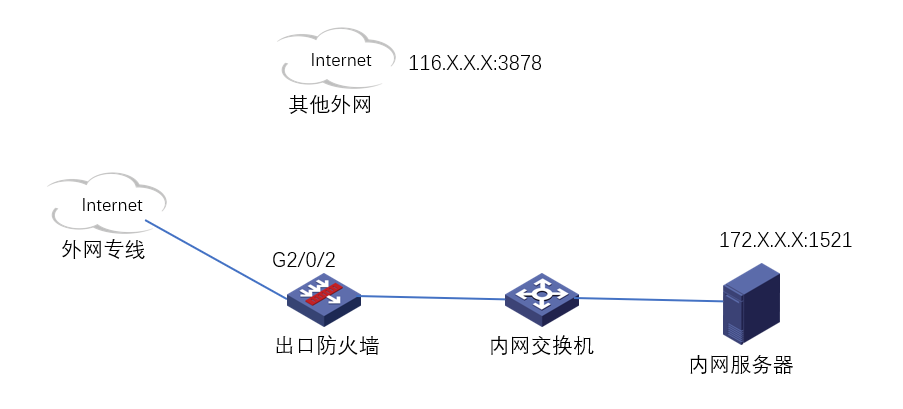

2. IP地址检查

如果一个IP地址在短时间内发送大量的请求,那么这个IP地址很可能是爬虫。网站可以通过检查请求的频率和数量来判断是否来自爬虫,并可能会封禁那些发送大量请求的IP地址。

3. 验证码

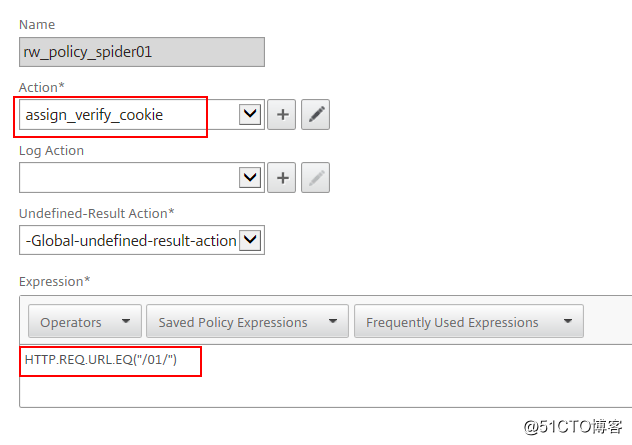

验证码是一种常见的防爬虫策略,它要求用户输入一个从图像、音频或者文本中获取的随机生成的代码。由于验证码需要人类的感知和理解能力,因此爬虫很难自动输入正确的验证码。

4. 动态页面

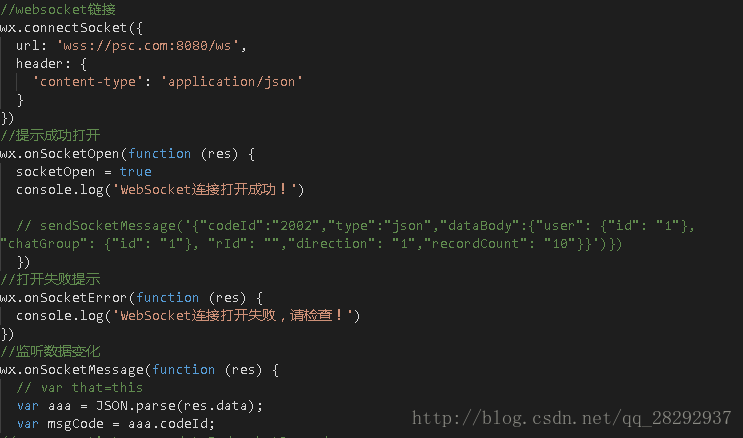

许多网站会使用或者Ajax来动态生成页面内容。爬虫如果不能正确处理这些动态生成的内容,那么它就不能正确爬取这些网站。

5. 协议

协议(也称为.txt文件)是网站告诉爬虫哪些页面可以爬取,哪些页面不能爬取的方式。虽然遵守协议是自愿的,但是许多爬虫会尊重这个协议,以避免被网站封禁。

以上就是一些常见的反爬虫策略,每一种策略都有其相应的反反爬虫技术。例如,对于User-Agent检查,爬虫可以使用真实的浏览器User-Agent;对于IP地址检查,爬虫可以使用代理服务器;对于验证码,爬虫可以使用OCR或者人工输入;对于动态页面,爬虫可以使用模拟浏览器的方式来爬取;对于协议,爬虫可以选择忽略它,但是这可能会导致被网站封禁。

总结

在爬虫过程中,网站为了保护自身的数据和服务,常常会采取各种反爬虫策略。以下是几种常见的反爬虫策略:

验证码():网站会在页面中加入验证码,要求用户进行人工验证。这种策略可以有效防止自动化机器人爬取数据,但也给正常用户带来不便。

User-Agent检测:网站会检测请求的User-Agent字段,如果发现异常或未知的User-Agent,可能会将请求识别为爬虫并进行拦截。为了规避这种策略,爬虫通常需要设置合理的User-Agent,模拟正常用户的请求头。

IP限制和封禁:网站会对频繁发送请求的IP进行限制或封禁,以防止爬虫的访问和抓取。为了规避这种策略,可以采用IP代理池,轮换使用不同IP地址进行爬取。

请求频率控制:网站会对同一IP地址的请求频率进行监控,并设置访问速率限制。当超出限制时,可能会拒绝服务或返回错误信息。为了规避这种策略,爬虫需要合理控制请求的间隔时间,避免过快的频繁请求。

动态数据加载:有些网站使用或Ajax等技术动态加载数据,而不是在初始HTML响应中返回完整的数据。这种情况下,爬虫需要模拟浏览器行为,执行代码,才能获取完整的数据。

数据混淆和加密:网站可能对关键数据进行混淆或加密,使其难以直接解析和提取。爬虫需要解密或逆向工程这些操作,才能正常获取目标数据。

登录和身份验证:部分网站在需要访问敏感数据或特定功能时,要求用户登录并进行身份验证。爬虫需要模拟用户的登录行为,提供有效的身份凭证,才能获取受限数据。

为了成功应对这些反爬虫策略,爬虫开发者需要先了解目标网站的反爬虫措施,并采取相应的应对策略。这可能包括使用代理IP、伪装请求头、处理验证码、解析动态数据、处理登录等复杂操作,同时也需要定期监测目标网站的变化,并进行相应的调整和优化。