Batch-Normlization 算子的实现

训练是为了更好的推理,就像我们学习是为了更高效的解决问题。好的开始是成功的一半,在神经网络的训练中,权重的初始值非常重要,很多时候,权重初始值的设定关系到神经网路的学习能否成功。这里的原因和各层的激活值分布有关,如果设定了合适的权重初始值,则各层的激活值分布会有适当的广度,从而可以顺利的进行学习。那么,为了使各层拥有适当的广度,“强制性”的调整激活值的分布会怎样呢?实际上,就是用来干这个的。

Batch

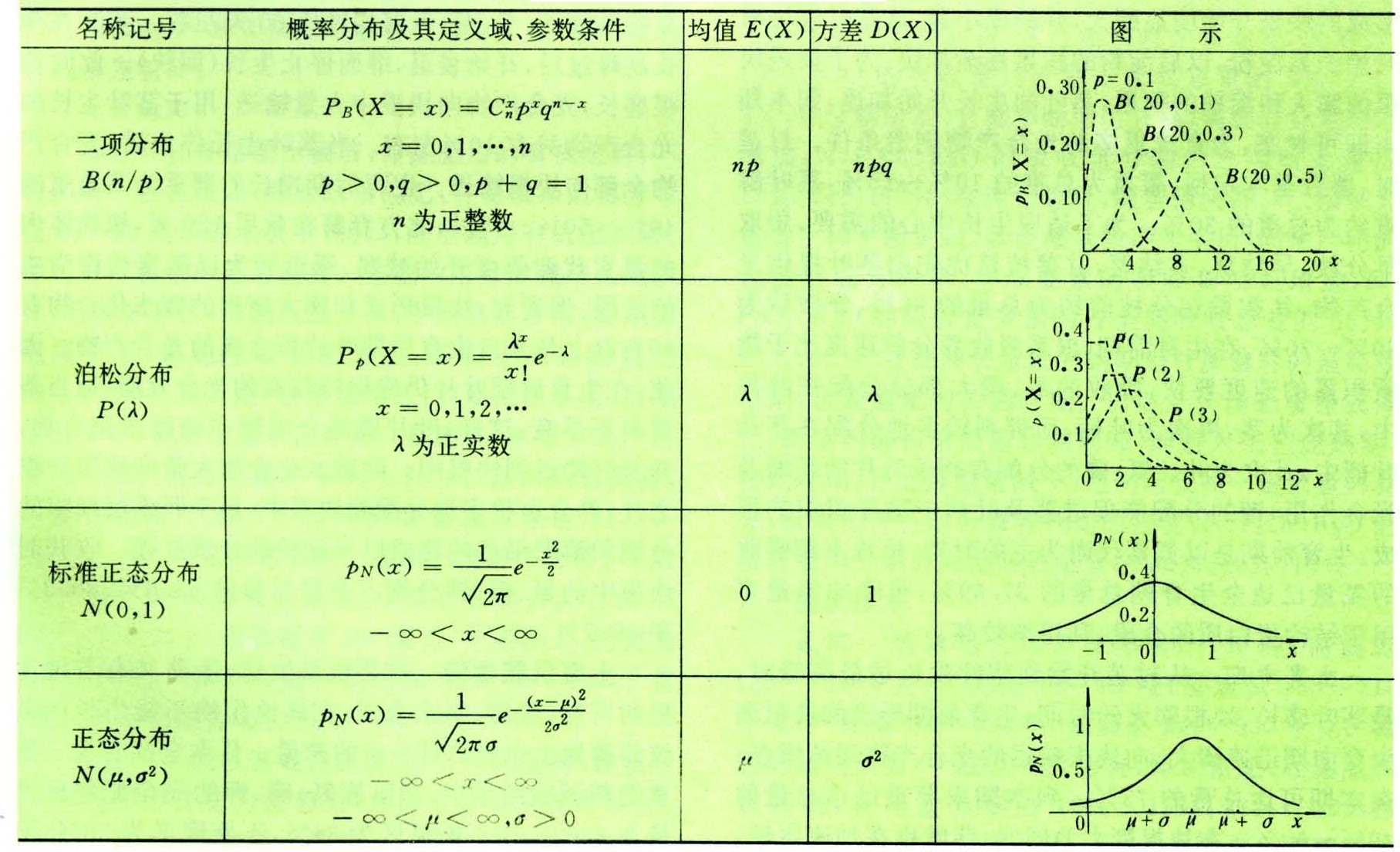

Batch 操作中文名是批量归一化,在技术领域,强行将一个英文术语翻译为中文并不会带来任何方便,反而原汁原味的原文词更能反映技术概念的内涵。Batch Norm是2015年提出的方法。虽然问世不久,但是已经被广泛使用了,实际上,看一下机器学习竞赛的结果,就会发现很多通过使用这个方法而获得优异结果的例子,为什么会这样呢? 因为大家普遍认为,Batch Norm有如下优点:

可以使学习快速的进行(可以增大学习率)不那么依赖初始值(对于初始值不那么敏感)抑制过拟合

Batch Norm的思路是调整各层的激活值分布使其拥有适当的广度。为此,要向神经网络中插入对数据分布进行正规化的层,即Batch Norm层,如下图所示:

Batch Norm,顾名思义,以进行学习时的mini-batch为单位,按mini-batch进行正规化,具体而言,就是进行使数据分布的均值为0,方差为1的正规化。用数学公式表达的话,如下所示:

这里对mini-batch的m个输入数据的集合

求均值

和方差

,然后,对输入数据进行均值为0,方差为1的正规化,式子中的

是一个微小值,他是为了防止出现除以0的情况。

式子的目的是将mini-batch的输入数据

变换为均值为0,方差为1的数据

非常简单,通过将这个处理插入到激活函数的前面或者后面,可以减小数据分布的偏向。接着Batch Norm层会对正规化后的数据进行平移和缩放的变换(就是仿射变换呗),用数学公式表示如下:

这里,

和

是参数,一开始

,

,然后再通过学习调整到合适的值。

BN操作并没有损失信息,如果令

则就能恢复原数据,所以

用流程图表示就是:

下面用代码实现:

#include

#include

#include

#include

#include

#include

#include

#include

#include #define DBG(fmt, ...) do { printf("%s line %d, "fmt"\n", __func__, __LINE__, ##__VA_ARGS__); } while (0)static void dump_memory(int *buf, int len)

{int i;printf("\n\rramdom number:");for (i = 0; i < len; i ++){if ((i % 10) == 0){printf("\n\rd:", i);}printf("d, ", buf[i]);}printf("\n\r");return;

}static void dump_memory_f(float *buf, int len)

{int i;printf("\n\rramdom number:");for (i = 0; i < len; i ++){if ((i % 10) == 0){printf("\n\rd:", i);}printf("%f, ", buf[i]);}printf("\n\r");return;

}float caculate_mean(int *buf, int len)

{float sum;int i;sum = 0.00f;for(i = 0; i < len; i ++){sum += buf[i];}return sum/len;

}float caculate_fangcha(int *buf, float mean, int len)

{float sum,tmp;int i;sum = 0.00f;for(i = 0; i < len; i ++){tmp = (buf[i] - mean);tmp *= tmp;sum += tmp;}return sqrt(sum / len);

}void find_max_min(float *buf, int len)

{float min,max;min = 101.0f;max = -1.0f;int i;for(i = 0; i < len; i ++){if(buf[i] > max){max = buf[i];}if(buf[i] < min){min = buf[i];}}DBG("max:%f, min %f.", max, min);return;

}int main(void)

{int array[100];float res[100];int i;for(i = 0; i < 100; i ++){array[i] = rand()0;}dump_memory(array, 100);float mean = caculate_mean(array, 100);DBG("mean = %f.", mean);float fangcha = caculate_fangcha(array, mean, 100);DBG("fangcha = %f.", fangcha);for(i = 0; i < 100; i ++) {res[i] = (array[i] - mean) / fangcha;}dump_memory_f(res,100);find_max_min(res, 100);return 0;

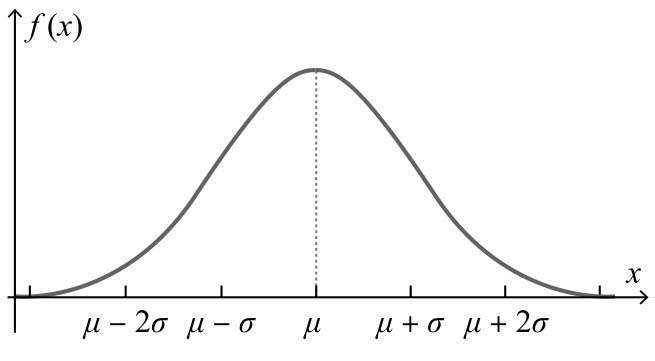

} 程序的逻辑基本上就是将数据位移均值的距离,移动到以0为中心,然后用标准差进行缩放。从而高斯化。

(调试这段程序遇到一个很有意思的现象,虽然和本文主题无关,但是觉得它反映的问题比较深刻,很有必要把它记录下来,就是在两台不同的PC上运行上面的程序,得到的随机数完全相同。看来LIBC库提供的随机数接口是真的“伪”随机接口阿。)

将上面生成的归一化参数输入,用hist函数画直方图。横坐标是数据,纵坐标表示分布概率。

使用 hist(list)绘制直方图

原始数据的直方图:

hist(w,20)查看分布细节:

我们看到,经过BN操作后,并没有影响到数据的分布结构,但对于训练过程来讲,可以很好地将数据“浓缩”在网络各层最适合运行区域,加快训练效率,另外也可以看到,如果原数据并非高斯分布,则BN仍旧保留原数据的分布,不会将其改变为高斯分布,结果不必是高斯分布。

高斯分布

w=-6+sqrt(10)*(randn(1,100000))

hist(w,50)BN在实际网络中的测试:

测试程序来源于以下链接:图灵社区

下载后,进入ch06目录,执行 .py,会看到如下输出:

程序中建立了两个同类型的网络,区别在于分别带有BN层和不带BN层,之后进行训练,并分析精度数据和训练效率。

学习参数:

BN将数据白化之后,还要进行一个仿射变换,仿射变换的系数分别就是

和

,这两个参数是需要训练的,也就是说,BN层给网络增加了可训练的参数数量。下面截图是程序中BN层的训练过程调用逻辑。

是shape的第一个成员

参考资料:

the pass Batch Layer

结束!