NLP 的 不可能三角?

作者|太子长琴

整理|

今天来看看 NLP 模型的不可能三角,并基于此一些未来的研究方向。

PLM 的不可能三角指的是:

中等模型大小(1B以下)

SOTA few-shot 能力

SOTA 微调能力

目前所有的 PLM 都缺其中一个或多个。很多注入知识蒸馏、数据增强、 的方法用以缓解这些缺失,但却在实际中带来了新的工作量。本文提供了一个未来的研究方向,将任务分解成几个关键阶段来实现不可能三角。

预训练模型已经广为人知,但人们并未在中小模型上发现 few-shot 甚至 zero-shot 的能力,大模型上的确有,但由于太大在实际使用时很不方便。而现实是很多时候我们没有过多标注数据,需要这种 few-shot 的能力。

不可能三角

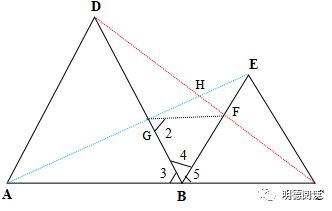

如下图所示:

一个很好的证据是 最近发表的 PaLM,论文发现,模型规模和 few/zero-shot 表现之间存在 不连续 的提升。比如说,与 8B 和 62B 的模型对比,PaLM 的 540B 在很多任务上表现出突破性的提升。

对于不可能三角,实际的 PLM 往往可以达到 1-2 个:

当前策略

对模型规模(缺 P1):

对较差的 zero/few-shot 能力(缺 P2):

对较差的有监督训练表现(缺 P3):

未来方法

本文提出了一种多阶段的方法。

这篇文章虽然篇幅不长,但切入点还挺有意思,也分析了针对各属性的缓解策略:知识蒸馏、数据增强、 学习等,并基于此提出了未来的研究方向,其实看起来是很自然的想法。不过这个不可能三角的确有点意思。

一起交流

想和你一起学习进步!『』目前已经建立了多个不同方向交流群(机器学习 / 深度学习 / 自然语言处理 / 搜索推荐 / 图网络 / 面试交流 /等),名额有限,赶紧添加下方微信加入一起讨论交流吧!(注意一定o要备注信息才能通过)

本文参考资料

[1]

: What's Next for Pre- ?: